金融 AI 大治理時代來臨!銀行公會新規修正上路

過去幾年,金融 AI 的關鍵字常是效率、獲客與降低成本,各銀行競相在沙盒實驗,試圖用演算法取代人力;不過,中華民國銀行公會 2025 年針對《金融機構運用人工智慧技術作業規範》進行修正,今年起金融 AI 的關鍵字可能變成治理、合規與可解釋性。這次修正不僅是對金管會《金融業運用人工智慧(AI)指引》的落實,更是對金融業演算法的全面體檢,也意味著 AI 在金融業的角色正式轉變為需被嚴格治理的風險資產。

銀行公會 AI 新規範上路!一分鐘速讀

監管範圍:適用範圍擴大,運用客戶資料、金融服務、交易權益相關 AI 全數納管。

監管核心:告別一刀切:導入「風險基礎方法」(RBA),依六大因子對高低風險分級管理。

生成式 AI 的緊箍咒:強制「人機協作」(人類負最終責)與「資料圍籬」(強烈引導封閉式部署)。

解析監管升級的三大推手

要理解這場變局,我們不能將其視為孤立的行政行為。銀行公會之所以選在 2025 年來調整,背後有著不可逆的三大推手,迫使監管思維從過去的「觀察與嘗試」轉向「主動治理」。

(一)歐盟效應的擴散

歐盟《人工智慧法》(EU AI Act)正式生效,確立了全球 AI 監管的黃金標準。歐盟採用「風險分級」的監管架構,嚴格禁止社會評分系統,並對高風險 AI 施加如重稅一般的合規義務。臺灣作為全球供應鏈與金融體系的一環,若法規無法與國際接軌,將面臨巨大的法規套利風險與跨境合作障礙。本次修正中引進「風險基礎方法(RBA)」,其法理精神正是源自歐盟,確保我國金融業在國際舞臺上具備同等的治理水準。

(二)國內法制環境的成熟

隨著《人工智慧基本法》在立法院三讀通過,等同國家層級確立了 AI 發展的七大原則及風險分級框架;而金融業作為高度監管行業,必須率先示範。特別是在「標示義務」與「弱勢群體保護」兩項目上,新版規範要求金融機構必須明確告知客戶「你正在與 AI 互動」,並確保演算法不會對特定族群產生歧視,這是金融內規對齊國家母法的必然結果。

關於金管會先前關於金管會先前發布的「金融業運用人工智慧 (AI) 之核心原則與相關推動政策」,馬克也有寫過相關的文章喔,歡迎參考:https://www.markreadfintech.com/p/ai-1a8

(三)生成式 AI「不可控」的恐懼

傳統的規範僅止於基礎的監管,面對 ChatGPT 等生成式 AI 時常常無能為力。GenAI 的「幻覺」風險、黑箱決策過程,以及可能無意間洩漏機敏資料的特性,讓監管機構擔憂,倘若不現在立下規矩,銀行有可能因為一個聊天機器人的失言、或是一次錯誤的生成式程式碼,而引發系統性風險。

法規修正內容

本次修正屬於結構性的擴張,舊版規範多聚焦於核心帳務系統或重大財務影響,新版則將「資料驅動」的所有場景納入管轄。

(一)適用範圍的結構性擴大

根據修正條文,只要 AI 應用涉及以下四類情境,無論技術底層是傳統機器學習還是最先進的大型語言模型,都將被納入監管範圍:

運用客戶資料之場景:即便 AI 僅用於銀行內部的行銷分析,只要涉及客戶個資(如消費行為標籤、刷卡地點),即受規範限制;此點直接衝擊了銀行內部的精準行銷與客戶畫像業務,屬於最顯著的擴張。

提供金融商品建議:涵蓋機器人理財、投資組合再平衡演算法等;這類應用直接影響客戶財富,屬於高風險範疇。

提供客戶服務:包括智能客服、語音助理等,規範要求必須確保 AI 的回應準確且無誤導性、並需揭露其非人類身分。

影響客戶金融交易權益:包括授信評分模型(決定借不借錢)、核保系統(決定保不保)、以及詐欺偵測系統(可能導致帳戶凍結)等;這類應用涉及對客戶的「准入」與「權利剝奪」,是公平性審查的焦點。

(二)風險矩陣的建立:RBA 的具體實踐

「一刀切」的監管模式已經不再,此次修正的核心靈魂在於導入「風險基礎方法」(RBA),監管機構授權金融機構依據自身業務特性來建立科學化的「風險矩陣」。

銀行必須考量以下六大關鍵因子來評估 AI 系統的風險等級:

對客戶或營運之影響程度:AI 判斷錯誤會賠多少錢?會不會害客戶貸不到款?

個人資料之使用:是用去識別化的數據,還是生物特徵?

AI 之自主性程度:是全自動決策(高風險),還是僅提供建議、由人類做主(低風險)?

系統複雜度:是簡單的決策樹,還是無法解釋的深度神經網路(Deep Learning)?

受影響之利害關係人範圍:是影響全行客戶,還是僅限特定部門?

救濟選項之完整性:當 AI 出錯時,客戶找得到真人申訴嗎?

用兩個實際情況來舉例:

一個全自動化的「小額信貸審核系統」,使用客戶個資、無人工覆核、演算法複雜 ➜ 屬於高風險系統,需要董事會核准、獨立驗證,並建立持續監控儀表板。

一個內部的「會議室預約建議系統」 ➜ 屬於低風險系統,僅需基本的資安控管即可。

(三)演算法公平性:拆解「數位歧視」

針對 AI 模型可能衍生的歧視問題,新規範列出必須審慎評估的「受保護特徵」,舉凡姓名、國籍、族群、出生地或居住所、年齡、性別等等。

這樣的「紅線」在實務上將帶來巨大衝擊。舉例而言,某銀行的授信模型發現「居住地(如特定偏鄉)」與違約率高度相關,進而導致該區域居民貸款核准率極低。在舊時代,這對銀行來說叫做「風險控管」;但在新時代,這可能構成「數位歧視」。

新規範要求,銀行必須證明使用這些特徵的「必要性」,否則必須尋求替代變數或進行「去偏見處理」。所有的評估結果、減緩作法及理由,都必須書面化留存,以備日後金檢時查核。

雙軌制與資料圍籬

有鑑於生成式 AI 的特殊性,本次修正特別為其開闢了專章,而這也成為許多銀行 IT 主管最頭痛的部分。

(一)雙軌治理策略

許多銀行採取「雙軌策略」:針對傳統「預測型 AI」與「生成式 AI」建立不同的治理軌道。生成式 AI 產出的內容具高度不確定性(如幻覺),因而被置於更嚴格的監控環境下,規範要求 GenAI 的應用需有更頻繁的覆核機制。

(二)資料圍籬與封閉式部署

能不能直接用 ChatGPT 寫信給客戶?答案是:不行,除非你有嚴格的資料圍籬。

規範強烈引導金融機構採用 「封閉型部署」模型,若必須使用公有雲,在傳輸過程中必須建立嚴格的資料圍籬,確保客戶的敏感個資(PII)不會被回傳給模型供應商進行訓練。這意味著銀行若要擁抱 GenAI,必須先解決資料落地與隔離的技術難題,將大幅增加 IT 基礎建設的成本。

(三)人機協作的最終防線

規範明確指出:「生成式 AI 產出之資訊,仍需由金融機構人員就其風險進行客觀且專業的管控」。這確立了「人機協作」的原則,意即銀行不能以「AI 出錯」作為免責理由。

舉例來說,若一位理財專員使用 AI 生成投資建議書,他必須親自審核內容,確認無誤導性資訊,方可發送給客戶;若建議書導致客戶虧損,銀行與理專得負起責任。

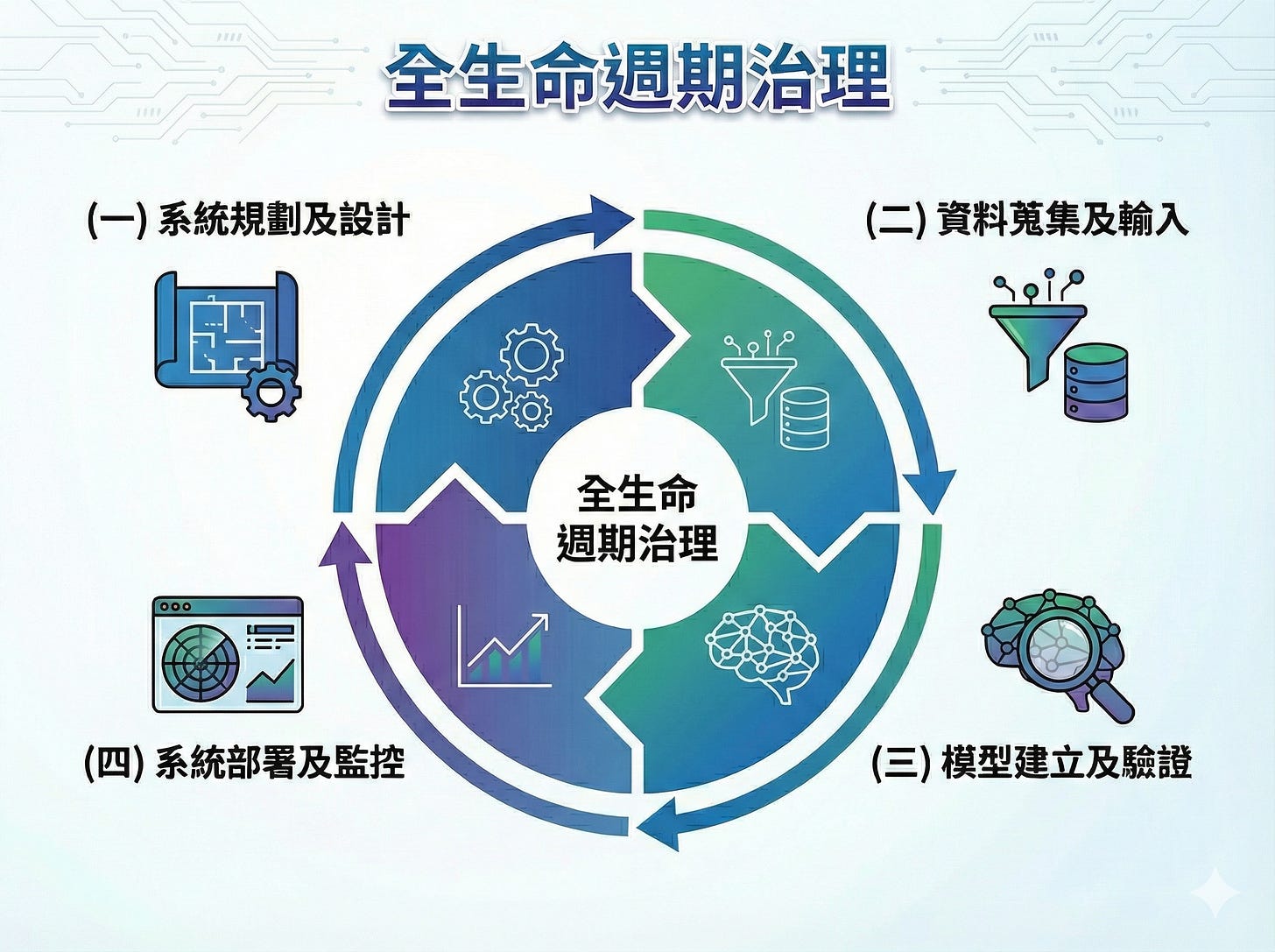

全生命週期治理

本次修正強調,AI 治理並非上線前的一次性審查,而是貫穿模型全生命週期的動態管理。規範將其嚴謹地定義為四個階段:

(一)系統規劃及設計

在工程師寫下第一行 Code 之前,合規就開始了。

預判:設計是否符合個資法?

定義成功:設定具體的效能門檻(如準確率需達 95% 以上)。

資料最小化:若公開資料已足夠,禁止蒐集非公開個資。

(二)資料蒐集及輸入

這是「垃圾進,垃圾出」的防守線。

資料多樣性:確保訓練數據具有代表性,避免因樣本偏差導致模型對特定群體預測失準。

來源合法性:必須詳細記錄「資料血緣(Data Lineage)」;若是購買第三方數據,必須審查其取得管道是否合法。

(三)模型建立及驗證

演算法選擇:除了效能,必須考量「可解釋性」。對於高風險場景,若深度學習模型的「黑箱」性質無法被解釋(即無法說明為何拒貸),則可能被禁止使用。

公平性測試:透過壓力測試,驗證模型對不同性別、年齡群體的輸出結果,確認無顯著偏差。

(四)系統部署及監控

上線不是結束,而是監控的開始。

模型漂移 :市場環境會變(例如疫情發生、央行升息),過去準確的模型可能今天就失效了。銀行必須建立儀表板,一旦發現效能衰退,需立即啟動重訓或退場機制。

透明性揭露:當 AI 與消費者互動時,必須明確告知客戶並尊重其選擇權。

對金融市場的影響

(一)誰是贏家?

先行者銀行:如 第一銀行(已率先導入 RBA 於徵授信)、華南銀行(採行雙軌策略)、台灣企銀(成立跨部門 AI 委員會)。這些銀行早已將治理提升至戰略層級,新規範對他們而言只是「將既有流程標準化」,反而拉高了競爭門檻。

合規科技(RegTech)業者:提供模型監控、偏見偵測、資料血緣追蹤工具的廠商將迎來爆發期,因為人工審查已不可行,自動化工具將成為剛需。

金融消費者:權益獲得更實質的保障,減少被冷冰冰的演算法莫名拒貸或歧視的風險。

(二)誰是輸家?

資源不足的中小型銀行:合規成本暴增。要建立符合規範的「三道防線」(業務、風控、稽核)與採購監控系統,對 IT 預算是一大負擔。

過度依賴「黑箱」的 AI 供應商:供應商若無法提供「模型可解釋性報告」或「資料來源合規證明」,恐將被銀行採購名單剔除。

(三)組織變革:三道防線的落實

要落實上述規範,銀行內部權力將發生重組,「AI 治理委員會」將成為跨部門的權力核心。

第一道防線:業務與 IT ➜ 負責開發,並在流程中嵌入合規節點。

第二道防線:法遵與風控 ➜ 負責制定政策、審查風險分級、挑戰模型的假設,將掌握「否決權」。

第三道防線:內部稽核 ➜ 負責獨立評估治理有效性,必須具備「演算法審計」的技能。

結論

(一)數位信任:創新的護城河

2025 年銀行公會的修正案,標誌著臺灣金融業 AI 發展進入了「治理為重」的新階段。這套規範雖然增加了短期的合規成本,但長遠來看,它是建立「數位信任」的基石。邏輯很簡單:

因為 AI 權力擴大(決定誰能借錢),所以需要更嚴格的治理(RBA 與公平性)。唯有如此,社會大眾才敢放心地將財富交給演算法管理。

(二)從業人員最好的準備方式

善用緩衝期,建立資產清冊:規範預留了一年的調整期,銀行應把握時間盤點現有的 AI 模型與數據資產,建立完整的 「AI 資產清冊」;必須先知道自己有什麼,才能知道風險在哪裡。

投資自動化工具:面對龐大的模型漂移監控需求,別試圖用 Excel 或人工來做。導入 MLOps(機器學習維運) 與 RegTech 工具,才能實時偵測偏見與效能衰退。

人才升級:這是最難的一步,銀行需培養「懂數據的法遵」與「懂法規的資料科學家」。填補這兩者之間的溝通鴻溝,是落實 RBA 的關鍵。

(三)2026 展望

隨著治理架構的完善,預計到 2026 年,臺灣金融業將從「AI 試驗」走向「AI 規模化」。屆時,具備高治理能力的銀行,將能推出更精準、更安全且符合倫理的普惠金融產品。這場監管風暴不是要扼殺創新,而是要篩選出「負責任的創新」。對於銀行而言,現在就是修築護城河的最佳時刻。

本文分析基於 2025 年銀行公會發布之修正文件與相關研究報告,實際執行細節請參閱各金融機構內部規章與主管機關最新公告。